Deepfake lidera opozycji wciąż cieszy się dużym zainteresowaniem, ponieważ eksperci ostrzegają, że brytyjska reakcja na fałszywe treści generowane przez sztuczną inteligencję ledwo wypływa na powierzchnię.

LONDYN — Wielka Brytania chce przewodzić światu w zakresie bezpieczeństwa sztucznej inteligencji, ale u siebie zmaga się z najpilniejszym zagrożeniem.

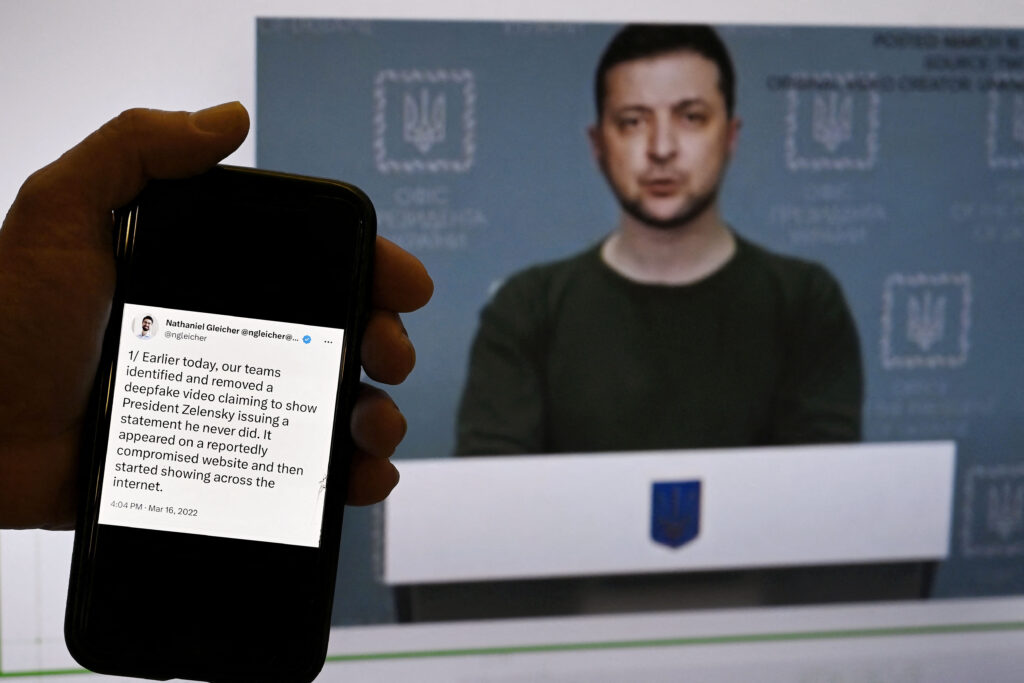

Obawy związane z rozprzestrzenianiem się mediów generowanych przez sztuczną inteligencję, znanych jako deepfakes, nasiliły się w ten weekend, gdy klip audio, który ukazuje przywódcę brytyjskiej opozycji Keira Starmera przeklinającego pracowników, stał się wirusowy.

W niedzielę parlamentarzyści z całego brytyjskiego spektrum politycznego szybko ostrzegli, że klip jest fałszywy. Jednak w poniedziałkowe popołudnie nadal zbierał wyświetlenia na X, wcześniej znanym jako Twitter, i osiągnął prawie 1,5 miliona odsłon.

Ankieta YouGov przeprowadzona w maju wśród ponad 100 brytyjskich parlamentarzystów wykazała, że wzrost liczby treści generowanych przez sztuczną inteligencję jest ich głównym problemem związanym z zastosowaniami sztucznej inteligencji. Łatwo zrozumieć dlaczego.

Minister cyfryzacji Partii Pracy Alex Davies-Jones powiedział w poniedziałek na marginesie konferencji partii w Liverpoolu, że nagrania Hansarda z posiedzeń parlamentarnych zapewniły złym aktorom bibliotekę „na żądanie” parlamentarzystów mówiących „prawie dowolnym słowem” – coś, co w ogromnym stopniu pomoże szkolenie modeli sztucznej inteligencji, aby przed wyborami w 2024 r. tworzyć jeszcze bardziej realistyczne podróbki polityków.

„Wyzwanie polega na wyjaśnieniu ludziom, że istnieje zupełnie inny rodzaj zagrożeń związanych z generatywną sztuczną inteligencją” – wyjaśnił Andrew Dudfield, szef sztucznej inteligencji w grupie Full Fact weryfikującej fakty.

Jednak pomimo wieloletnich ostrzeżeń dotyczących dezinformacji wyborczej żaden organ regulacyjny nie jest odpowiedzialny za jej powstrzymanie, a reakcja rządu na fałszywe treści za pośrednictwem ustawy o bezpieczeństwie w Internecie ledwo zaczyna rozwiązywać problem – ostrzegają eksperci.

Publikowanie dezinformacji w celu osłabienia przeciwników politycznych nie jest niczym nowym, ale tym, co nie daje spać ekspertom w nocy, jest łatwość i skala, z jaką postęp w zakresie generatywnych narzędzi sztucznej inteligencji umożliwia rozprzestrzenianie się fałszywych materiałów.

Niektórzy mieli nadzieję, że ustawę o bezpieczeństwie w Internecie uda się wykorzystać do zwalczania wzrostu liczby fałszywych informacji przed przyszłorocznymi wyborami w Wielkiej Brytanii.

Jednak Dudfield z Full Fact opisuje już ukończone ustawodawstwo jako „straconą szansę”. „Trudno dostrzec, jak w znaczący sposób odnosi się to do jakiejkolwiek części dezinformacji” – stwierdził.

Ustawa upoważnia organ regulacyjny Ofcom do zapewnienia, że platformy chronią użytkowników, w szczególności dzieci, przed „szkodliwymi treściami”, ale jeśli chodzi o dezinformację, platformy ustalają własne zasady i przestrzegają ich. Jedyne, co Ofcom może zrobić, to sprawdzić, czy ich przestrzega.

Warunki korzystania z usług platform nie powstrzymują rozprzestrzeniania się dezinformacji. X zasady to stwierdzają użytkownikom „nie wolno udostępniać syntetycznych, zmanipulowanych ani wyrwanych z kontekstu multimediów”, ale nie powstrzymało to klipu Starmera.

Rzecznik Ofcom powiedział, że utworzy on „komitet doradczy” ds. problemu w ramach ustawy o bezpieczeństwie w Internecie oraz że prowadzi również badania nad deepfakes i znakami wodnymi, dodał jednak, że jest to na wczesnym etapie.

Jest to dalekie od zaleceń komisji Izby Lordów na rok 2020.

Ustawodawcy z Komisji ds. Demokracji i Technologii Cyfrowych chcieli, aby przepisy ustawy o bezpieczeństwie w Internecie zmusiły platformy do podejmowania działań przeciwko treściom podważającym demokrację. Zaleciła także organom regulacyjnym powołanie potężnej komisji, która zajmie się reklamą polityczną.

Komitetowi Lordów przewodniczył kolega z Partii Pracy David Puttnam, który jest obecnie na emeryturze, ale nadal jest aktywny w tej dziedzinie za pośrednictwem grupy o nazwie Reform Political Advertising (RPA).

„Jestem bardzo zły. Bardzo trudno mi prowadzić tę rozmowę” – powiedział TylkoGliwice. „Za rok wkraczamy w wybory powszechne i żadna partia tak naprawdę nie podniesie ręki, mówiąc, że to musi się skończyć”.

Oznajmił, że obawia się, że „stanie się coś strasznego”, jeśli strony nie podejmą zobowiązań w zakresie zwalczania dezinformacji.

Rae Burdon z Reform Political Advertising (RPA) ostrzegła: „Żaden departament rządowy nie jest w stanie naprawić deepfakes. Mogą naprawić regulacje, które będą skutkować ograniczeniem i sankcjonowaniem ich stosowania”.

W Wielkiej Brytanii nie brakuje organów regulacyjnych, ale żadnego z nich nie można powstrzymać dezinformacji wyborczej. Reklamy polityczne są wyłączone spod kontroli Agencji ds. Standardów Reklamowych (ASA), podczas gdy Komisja Wyborcza zajmuje się wyłącznie finansowaniem kampanii.

Jedną z możliwych grup, w których organy regulacyjne mogłyby się spotykać, aby przeciwdziałać dezinformacji generowanej przez sztuczną inteligencję, jest Forum Współpracy w zakresie Regulacji Cyfrowych (DRCF). Jest to jednak dobrowolna grupa organów regulacyjnych, nieposiadająca ustawowych uprawnień. Rzecznik powiedział, że nie pracują nad dezinformacją generowaną przez sztuczną inteligencję i odmówił udzielenia wywiadu.

Ministrem odpowiedzialnym za walkę z dezinformacją jest Paul Scully. W czerwcu list do posła Partii Pracy Darren Jones, który wyraził swoje obawy dotyczące dezinformacji generowanej przez sztuczną inteligencję podczas wyborów, Scully wskazał na ustawę o wyborach, która wchodzi w życie w listopadzie, aby „wzmocnić uczciwość wyborów w Wielkiej Brytanii”.

Daje ona Komisji Wyborczej nowe uprawnienia w zakresie egzekwowania „cyfrowych nadruków” na materiałach kampanii, które informują widzów, kto zapłacił za reklamę w Internecie i kto ją wyprodukował.

Louise Edwards, dyrektor ds. regulacji i transformacji cyfrowej w Komisji, stwierdziła, że ustawa ta stanowi „duży krok naprzód”, ale brakuje w niej kilku kluczowych zaleceń. Podkreśliła, że nadal nie ma sposobu na sklasyfikowanie wydatków na technologie cyfrowe, aby społeczeństwo mogło zobaczyć, w jaki sposób partie polityczne wydają środki finansowe na kampanie.

Nie ma to znaczenia w przypadku fałszywych klipów pochodzących z kont niepowiązanych z partiami politycznymi, takich jak klip audio Starmer.

Scully podkreśliła także pracę jednostki rządowej zwanej Jednostką ds. Zwalczania Dezinformacji (CDU) w zwalczaniu dezinformacji w Internecie. Jednak grupa była atakowana przez negatywną prasę, a ministrowie próbowali się od niej zdystansować.

CDU reaguje na „okresy ostrego ryzyka dezinformacji” – stwierdziła Scully wraz z dwiema innymi grupami rządowymi zwanymi Komórką Wyborczą i Grupą Zadaniową ds. Obrony Demokracji. Wysiłki te skupiają się jednak na podmiotach międzynarodowych podważających wybory w Wielkiej Brytanii, a nie na krajowej dezinformacji.

W listopadzie Wielka Brytania jest gospodarzem szczytu dotyczącego bezpieczeństwa sztucznej inteligencji, którego celem jest omówienie zagrożeń związanych z najbardziej zaawansowanymi modelami, znanymi jako Frontier AI. Wpływ na wybory to jeden z kilku omawianych tematów.

Rzecznik rządu powiedział: „Wiemy, jakie zagrożenie mogą stanowić treści zmanipulowane cyfrowo, i podchodzimy do tego problemu bardzo poważnie. Naszym priorytetem jest zawsze ochrona naszych wyborów i podejmowanie działań w odpowiedzi na wszelkie zagrożenia dla procesów i instytucji demokratycznych w Wielkiej Brytanii”.

Niezależnie od tego, co zrobią rządy, duża część rozwiązania leży po stronie firm technologicznych.

Jedną z nadziei, na którą powołują się te firmy, jest znak wodny, który umieszczałby znak na treści, wskazując, że została wygenerowana przez sztuczną inteligencję. W lipcu w Białym Domu siedem największych firm zajmujących się sztuczną inteligencją zobowiązało się do „opracowania solidnych mechanizmów technicznych, które pozwolą użytkownikom wiedzieć, kiedy treść jest generowana przez sztuczną inteligencję, np. systemu znaków wodnych”.

Dudfield stwierdził, że był to mile widziany krok, ale wskazał, że nadal potrzeba wiele pracy, szczególnie w zakresie znaków wodnych. „Podstawowa technologia istnieje” – wyjaśnił. „Ale kto oznacza treść? Czy jest to platforma osoby, która ją stworzyła?”

Ustalenie, w jaki sposób Big Tech będzie realizować zobowiązania Białego Domu, jest jednym z głównych tematów brytyjskiego szczytu dotyczącego bezpieczeństwa sztucznej inteligencji.

Google należy do firm zastanawiających się, jak dodawać znaki wodne do treści i pod koniec sierpnia uruchomił test tej technologii. Platformy mogą również opierać się na istniejących zespołach i politykach dezinformacyjnych, które zakazują fałszywych treści generowanych przez sztuczną inteligencję.

Inne sugerowane rozwiązania branżowe obejmują zakres od skromnych po skrajne. Sam Altman z OpenAI, który napisał na Twitterze o swoich obawach przed wyborami w sierpniu wezwał do „podnoszenia świadomości”. Tymczasem założyciel Inflection AI, Mustafa Suleyman, był znacznie bardziej dosadny, pisząc na LinkedIn, że AI należy zakazać „jakiejkolwiek agitacji wyborczej”.

Ale Puttnam nie zgodził się z tym i argumentował, że należy je zamiast tego wykorzystywać do zwiększania zaufania. „Dzięki narzędziom łatwiej jest nam rozpoznać, kiedy ktoś kłamie” – stwierdził. „Pytanie, które należy zadać stronom, brzmi: czy zamierzacie poświęcić czas, wysiłek i energię na to, jak wykorzystać je do dezinformacji lub jak powstrzymać dezinformację?”

![Vincent van Gogh, Kop van een vrouw (Gordina de Groot) (Head of a Woman [Gordina de Groot]), 1885.](https://tylkogliwice.pl/wp-content/uploads/2024/12/1734223076_Holenderskie-muzeum-kupuje-obraz-Van-Gogha-nazywany-„Mona-Lisa-Brabancji-150x150.jpg)