Algorytmy odzwierciedlają społeczeństwo, które je stworzyło, kierując się logiką, że aby sprostać konkretnym wyzwaniom, ustawodawstwo powinno odzwierciedlać społeczeństwo, a nie tylko same algorytmy, pisze Yonah Welker.

Zaledwie kilka tygodni po podpisaniu deklaracji Bletchleya przez 28 krajów, które zgodziły się na podejście oparte na ryzyku do granicznej sztucznej inteligencji, obszarów, rodzajów i przypadków zagrożeń, w tym zdrowia, edukacji, pracy i praw człowieka.

Następnie Stany Zjednoczone wydały pierwsze rozporządzenie wykonawcze dotyczące sztucznej inteligencji, wymagające oceny bezpieczeństwa, wytycznych w zakresie praw obywatelskich i badań nad wpływem na rynek pracy, czemu towarzyszyło również utworzenie Instytutu Bezpieczeństwa AI.

Równolegle Wielka Brytania wprowadziła Instytut Bezpieczeństwa AI oraz ustawę o bezpieczeństwie w Internecie, nawiązując do podejścia przyjętego w Unii Europejskiej i ustawie o usługach cyfrowych.

Pomimo ogólnego porozumienia kraje nadal znajdują się na różnych etapach wdrażania tej wizji, obejmujących tworzenie organów nadzoru, tworzenie wymaganych zdolności, ocenę opartą na ryzyku i infrastrukturę oraz łączenie istniejącego prawodawstwa, dyrektyw i ram.

Istnieją również różne podejścia do egzekwowania tego nadzoru, począwszy od bardziej rygorystycznego podejścia w UE – prowadzącego do obecnego sprzeciwu ze strony twórców podstawowych modeli, w tym niemieckiego Aleph Alpha i francuskiego Mistrala – po raczej „miękkie” podejście w Wielkiej Brytanii .

Istnieją jeszcze ważniejsze kwestie związane z konkretnymi obszarami wysokiego ryzyka, które wymagają większej uwagi, takimi jak policja, wymiar sprawiedliwości i systemy prawne, zdrowie, edukacja i wyznaczone grupy.

Jest to szczególnie ważne w przypadku grup takich jak osoby niepełnosprawne, dzieci i inne grupy społeczne.

Złożone zadanie dla polityki i technologii

Wiadomo na przykład, że wiele legalnych systemów sztucznej inteligencji zostało przeszkolonych bez udziału określonych populacji, co doprowadziło do większej liczby błędów w ich przypadku. W niektórych krajach agencje rządowe zostały oskarżone o wykorzystywanie danych z mediów społecznościowych bez zgody pacjentów do potwierdzania stopnia niepełnosprawności pacjentów na potrzeby programów emerytalnych.

Imigranci zwykle unikają badań i testów lekarskich w obawie przed deportacją lub poniesieniem nieakceptowalnych kosztów leczenia, dlatego statystyki i zbiory danych publicznych po prostu tego nie odzwierciedlają.

Wreszcie sztuczna inteligencja może nieprawidłowo identyfikować osoby pozbawione kończyn, z różnicami w twarzy, asymetrią, zaburzeniami mowy, odmiennymi stylami komunikacji lub gestykulacją, a także osoby korzystające z urządzeń wspomagających.

W innym przykładzie systemy rozpoznawania twarzy mogą wykorzystywać kształt ucha lub obecność kanału słuchowego w celu ustalenia, czy obraz przedstawia ludzką twarz. Jednak może nie działać w przypadku grup z zespołami twarzoczaszki lub pozbawionych tych części.

Od czasu przedstawienia pierwotnego wniosku w sprawie unijnej ustawy o sztucznej inteligencji w 2021 r. Komisja Europejska otrzymuje odwołania i uwagi dotyczące sztucznej inteligencji i praw osób niepełnosprawnych, stosowania systemów biometrycznych, systemów rozpoznawania twarzy i emocji, a także spraw dotyczących uchodźców i imigrantów, w tym automatycznej oceny ryzyka i profilowania systemy.

Jednak badania i rozwój systemów sztucznej inteligencji ukierunkowanych na niepełnosprawność są nadal złożonym zadaniem zarówno z punktu widzenia technologii, jak i polityki.

Obejmuje to jego przekrojowy charakter, stan, wiek, płeć i parametry specyficzne dla widma, a także zaangażowanie wielu ram prawnych w celu odpowiedniego rozwiązania tego problemu i jego ochrony.

Zwiększa rolę ram niezwiązanych wyłącznie ze sztuczną inteligencją, takich jak akt o dostępności, unijne akty prawne dotyczące usług cyfrowych i rynku, Konwencja o prawach osób niepełnosprawnych, przepisy dotyczące równości i ochrony dzieci, zaangażowanie wyspecjalizowanych instytucji i agencji wielostronnych, co nadchodzi wykraczające poza samo tworzenie ogólnych „instytutów bezpieczeństwa AI”.

UE, sztuczna inteligencja, wyznaczone grupy i ekosystemy prawne

Należy pamiętać, że regulacje dotyczące systemów sztucznej inteligencji dotyczące wyznaczonych grup lub osób niepełnosprawnych nie ograniczają się do jednego dokumentu prawnego, ale są raczej przedstawiane w formie spektrum ram prawnych, przepisów, konwencji i polityk.

W szczególności takie przypadki mogą być regulowane lub mogą mieć na nie wpływ akty dotyczące sztucznej inteligencji, powiązane dane, ramy dotyczące praw konsumentów i praw człowieka, memoranda i konwencje.

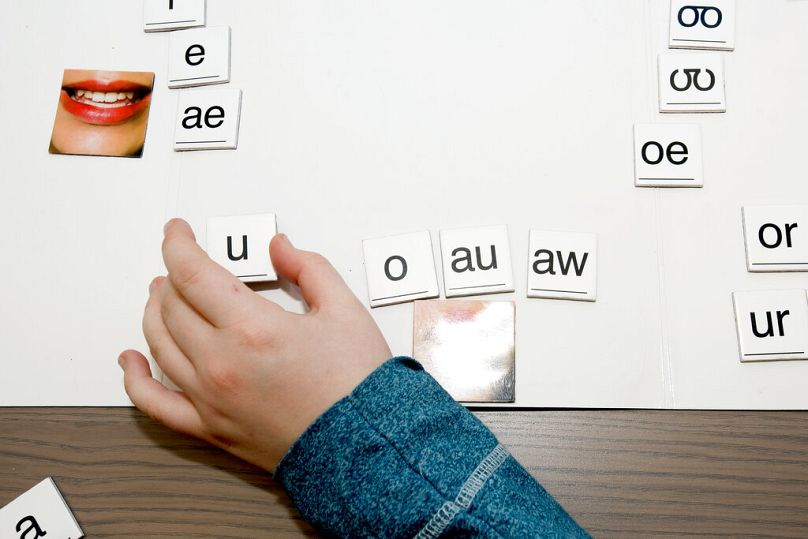

Na przykład na technologię wspomagającą stosowaną w celu wspierania dysleksji lub autyzmu mogą mieć wpływ artykuły ustawy o sztucznej inteligencji, regulacje dotyczące danych, szczegółowe przepisy chroniące dzieci i wyznaczone grupy, takie jak Konwencja o prawach osób niepełnosprawnych, oraz zasady równości i niepełnosprawności obowiązujące w poszczególnych krajach. -przepisy dotyczące dyskryminacji.

Komisja Europejska zaczęła badać sposoby rozwiązania problemu systemów sztucznej inteligencji i związanych z nimi konkretnych zagrożeń jeszcze przed pełnym wprowadzeniem ustawy o sztucznej inteligencji.

W szczególności w istniejącym już wcześniej RODO (ogólne rozporządzenie o ochronie danych) znalazły się artykuły związane z profilowaniem wyznaczonych grup, wykorzystaniem danych opartych na „rasie” i „płci”, ochronie nieletnich, systemach i danych biometrycznych oraz rozpoznawaniu twarzy.

Tworzenie bezpieczniejszej przestrzeni cyfrowej

Z punktu widzenia wyznaczonych grup istotną rolę odgrywa także ustawa o usługach cyfrowych (równolegle z ustawą o rynku cyfrowym).

Chociaż nie dotyczy to wyłącznie sztucznej inteligencji, ma na celu „stworzenie bezpieczniejszej przestrzeni cyfrowej, w której chronione są podstawowe prawa użytkowników”.

W szczególności wprowadza wymogi dotyczące przejrzystości platform internetowych, odpowiedzialności, wyjaśnialności stosowanych algorytmów, stosowania „ciemnych wzorców”, ochrony nieletnich, targetowania i profilowania, prywatności i zgody, manipulacji, wprowadzenia „zaufanych osób zgłaszających” i moderatorów, pętla informacji zwrotnej między platformami a zainteresowanymi stronami, wyznaczonymi „koordynatorami usług cyfrowych w państwach członkowskich”.

Mechanizmy te pomagają lepiej uwzględniać ochronę użytkowników, współpracę między państwami członkowskimi, dochodzenia i ramy prawne, w tym zaangażowanie odpowiednich sądów i organów jurysdykcyjnych.

Towarzyszy jej ustawa o dostępności z 2025 r., której celem jest poprawa funkcjonowania rynku wewnętrznego dostępnych produktów i usług poprzez usunięcie barier tworzonych przez rozbieżne przepisy w państwach członkowskich.

Wreszcie wysiłki te są wspierane przez agencje wielostronne, takie jak UNESCO, WHO i OECD, pracujące nad wytycznymi dla poszczególnych obszarów dotyczącymi generatywnej sztucznej inteligencji w edukacji, opiece zdrowotnej, umiejętności czytania i pisania oraz zaleceniami zorientowanymi na możliwości.

Zawiera ramy kompetencji UNESCO w zakresie sztucznej inteligencji dla uczniów i nauczycieli lub zalecenie ustalenia minimalnego wieku na 13 lat, od którego można korzystać generatywnej sztucznej inteligencji.

Co więcej, na jego niedawny plan działania mający na celu zajęcie się dezinformacją i szkodami wyrządzanymi przez media społecznościowe zebrano odpowiedzi ze 134 krajów, w tym z Afryki i Ameryki Łacińskiej.

Specjalizacja, współpraca i droga naprzód

Algorytmy odzwierciedlają społeczeństwo, które je stworzyło, kierując się logiką, że aby sprostać konkretnym wyzwaniom, ustawodawstwo powinno odzwierciedlać społeczeństwo, a nie tylko algorytmy.

Ograniczanie ryzyka algorytmów w stosunku do wyznaczonych grup jest raczej złożonym procesem, który powoduje zwiększoną rolę prawodawstwa niezwiązanego wyłącznie z sztuczną inteligencją i wykracza poza samo tworzenie „Instytutów Bezpieczeństwa AI”.

Obejmuje to budowanie kategorii ryzyka i oceny skutków specyficznych dla tych grup, uwzględnienie czynników społecznych i historycznych stojących za algorytmami, zapewnienie dostępu do danych oraz nadzór i uczestnictwo wielu zainteresowanych stron.