Nasze rządy muszą być skłonne włożyć pieniądze w swoje usta, zapewniając, że wykorzystanie sztucznej inteligencji przez państwo podlega tym samym rozsądnym zasadom i wymogom, co każdy inny system sztucznej inteligencji, pisze Ella Jakubowska.

Obietnice rozwiązania największych problemów społeczeństwa, a także twierdzenia o zagrożeniu wyginięciem człowieka wydają się być najgorętszymi tematami związanymi ze sztuczną inteligencją, które dominują na pierwszych stronach gazet.

Jednak to skupienie się na obiecanej odległej przyszłości często odwraca uwagę od rzeczywistych i obecnych zagrożeń.

Jedną z kwestii, którą niebezpiecznie przeoczyliśmy, jest to, że wykorzystanie systemów sztucznej inteligencji pogłębi i tak już ogromną nierównowagę sił między państwami i ludźmi.

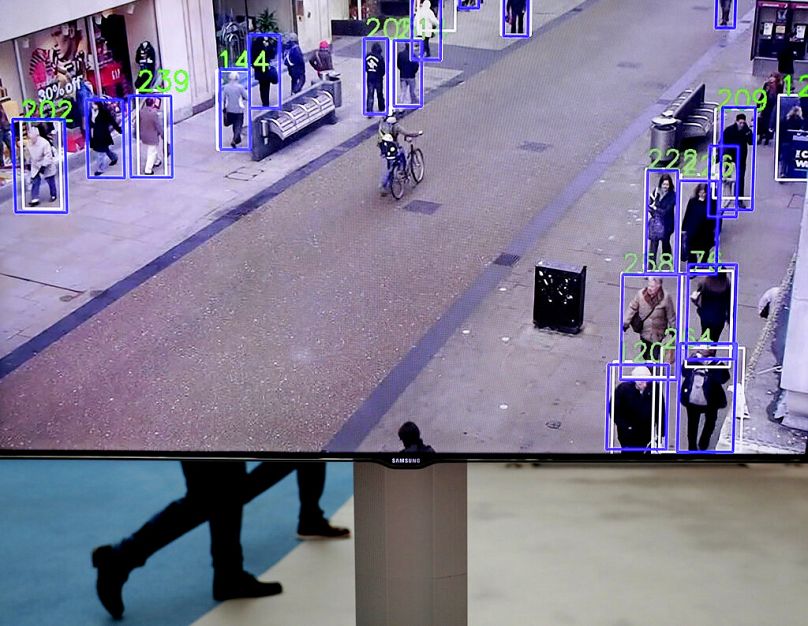

Powinno to niepokoić każdego z nas, ponieważ policja i inne władze korzystają z technologii sztucznej inteligencji. Szybko rosnące wykorzystanie systemów sztucznej inteligencji w policji, na granicach, w opiece społecznej i w edukacji nie do poznania przekształca administrację publiczną i przestrzeń publiczną.

Najwyższy czas, abyśmy zastosowali ugruntowane zasady proceduralne i zabezpieczenia w kontekście sztucznej inteligencji. Twierdzenia, że „nadmierna regulacja” „zabije” innowacje, to czerwony śledź, odwracający uwagę od faktu, że i tak już nieproporcjonalna kontrola rządów – i korporacji – nad naszym życiem zostanie ugruntowana, jeśli nie zastosujemy tych samych kontroli i równowagi w systemach sztucznej inteligencji, co robimy we wszystkich innych obszarach życia.

Jednak rządy UE ostro się sprzeciwiają, próbując pozbawić wszelkie znaczenie prób legislacyjnych mających na celu ochronę ludzi przed najbardziej szkodliwymi zastosowaniami sztucznej inteligencji.

Akt UE dotyczący sztucznej inteligencji dobiega końca

W UE długo oczekiwana ustawa o sztucznej inteligencji wchodzi w końcową fazę negocjacji. Jedną z kluczowych zasad tej ustawy zawsze było to, że ludzie i społeczeństwa muszą móc „zaufać” w korzystaniu z systemów sztucznej inteligencji, w szczególności wiedząc, że ryzykowne systemy są odpowiednio regulowane i że wyjątkowo ryzykowne systemy są zabronione.

Działacze na rzecz praw obywatelskich argumentują, że należy całkowicie zakazać praktyk inwazyjnych i manipulacyjnych, takich jak publiczne rozpoznawanie twarzy i zapobiegawcze działania policji. Biometryczny masowy nadzór nad protestami, ulicami handlowymi, parkami i innymi przestrzeniami publicznymi nie może być akceptowany w wolnym społeczeństwie.

Jednak próby Parlamentu Europejskiego mające na celu uniemożliwienie rządom korzystania z systemów sztucznej inteligencji w ten sposób są blokowane przez co najmniej dwadzieścia sześć rządów państw członkowskich UE.

Te państwa członkowskie przedkładają wygodę, a nawet cele oszczędnościowe, nad odpowiednie kontrole i równowagę, które chroniłyby nas przed krzywdą ze strony ryzykownych systemów sztucznej inteligencji.

Podstawowym argumentem rządów UE było to, że musimy ufać im, że będą korzystać z tych systemów w sposób zapewniający nam bezpieczeństwo. Argumentowali, że zakazy są zbyt tępym instrumentem i że zabezpieczenia wystarczą, aby zapobiec nadużyciom.

Na zaufanie do policyjnej sztucznej inteligencji trzeba zasłużyć

Jednak jeśli chodzi o inne zastosowania sztucznej inteligencji przez państwo, narracja nie może być bardziej odmienna.

Te same rządy, które proszą nas, abyśmy zaufali im, że będą korzystać z publicznego rozpoznawania twarzy i predykcyjnych działań policji w „bezpieczny” sposób, to te same rządy, które twierdzą, że nie powinny być zmuszone do przestrzegania zasad sztucznej inteligencji, jeśli chodzi o najniebezpieczniejsze zastosowania sztucznej inteligencji przez państwo — jak wykorzystanie sztucznej inteligencji przez policję i władze migracyjne.

To właśnie w tych przypadkach najbardziej potrzebujemy przejrzystości i odpowiedzialności. Technologie cyfrowe nie zmieniają faktu, że w przypadku policji za zgodą państwa polegają na woli i zaufaniu ludzi, którymi rządzą.

Ale jak mamy ufać naszym rządom, że bezpiecznie będą korzystać z systemów sztucznej inteligencji, skoro odmawiają one przestrzegania jakichkolwiek zasad, które chroniłyby nas przed szkodami, jakie może wyrządzić ta potencjalnie niebezpieczna technologia?

Państwa UE nie zdobędą zaufania obywateli, utrzymując w cieniu wykorzystanie technologii sztucznej inteligencji, odrzucając kontrole gwarantujące bezpieczny projekt systemu ani zezwalając na pozbawione skrupułów transakcje z głodnymi zysku korporacjami zajmującymi się sztuczną inteligencją.

Nieprzejrzystość i technokracja branży sztucznej inteligencji sprawiają, że zapewnienie społeczeństwu rozsądnego wglądu w to, w jaki sposób nasze rządy korzystają z tych systemów, staje się jeszcze ważniejsze niż kiedykolwiek.

Bez tej przejrzystości ryzykujemy posiadaniem systemów sztucznej inteligencji, które pogłębiają dyskryminacyjne i szkodliwe wzorce, wciągając ludzi w pętle fałszywych oskarżeń i procesów opartych na algorytmach.

Zakaz najbardziej niebezpiecznych zastosowań

Pomimo twierdzeń jastrzębich urzędników rządowych i dostawców systemów sztucznej inteligencji zakazy niedopuszczalnie szkodliwego wykorzystania systemów sztucznej inteligencji nie są tępym instrumentem.

W kontekście praw człowieka mówimy o spektrum zabezpieczeń: od bardziej minimalnych zabezpieczeń dla mniej ryzykownych systemów, aż po całkowity zakaz, gdy wiemy, że coś jest po prostu niezgodne ze sprawiedliwym społeczeństwem.

Rzeczywistość jest taka, że jedynie bardzo niewielka liczba dobrze zdefiniowanych przypadków użycia sztucznej inteligencji rozważana jest w sprawie wprowadzenia ogólnounijnego zakazu w ustawie o sztucznej inteligencji. Nawet wtedy państwa członkowskie wydają się skłonne do robienia wyjątków.

Weźmy publiczne rozpoznawanie twarzy – zgodnie z pierwotnym projektem zakazowi miałoby podlegać wyłącznie korzystanie z systemów „w czasie rzeczywistym”, „na odległość” przez policję i „w przestrzeni publicznie dostępnej”.

Opóźnij dopasowanie o godzinę, zrób to w kiosku lub urzędzie administracji, albo w dowolnej innej liczbie wyjątków, a nie będzie już zabronione.

Grupy społeczeństwa obywatelskiego argumentowały jednak, że ochrona prawa do prywatności, godności, wolności wypowiedzi i równości wymaga całkowitego zakazu masowej inwigilacji i arbitralnego stosowania systemów biometrycznych, a także ścisłej kontroli innych zastosowań. Rządy UE nalegają jednak na wprowadzenie zabezpieczeń tak słabych, że nie mają one znaczenia.

Problem podwójnego myślenia

Podwójne myślenie rządów UE w tych kwestiach świadczy o braku merytorycznej ich argumentacji.

Na przykład niedawne rozporządzenie wykonawcze Stanów Zjednoczonych w sprawie sztucznej inteligencji pokazało, że rzeczywiście możliwe jest włączenie organów ścigania i agencji bezpieczeństwa narodowego w zakres przepisów dotyczących sztucznej inteligencji.

Nasze rządy muszą być skłonne włożyć pieniądze w swoje usta, zapewniając, że wykorzystanie sztucznej inteligencji przez państwo podlega tym samym rozsądnym zasadom i wymogom, co każdy inny system sztucznej inteligencji.

A w niewielkiej liczbie przypadków, w których wykazano, że stosowanie sztucznej inteligencji jest po prostu zbyt szkodliwe, aby było bezpieczne, potrzebne są zakazy.

Bez tego nie będziemy mogli ufać, że unijna ustawa o sztucznej inteligencji rzeczywiście traktuje ludzi i prawa jako priorytet.