W walentynki „bratnie dusze AI” dają popalić, sprzedając lub udostępniając Twoje dane osobowe stronom trzecim, takim jak Facebook.

W te Walentynki zamiast romantycznego wieczoru z bliskimi niektórzy ludzie mogą umawiać się na wirtualne randki z romantycznymi chatbotami opartymi na sztucznej inteligencji (AI).

Jednak według nowego raportu tym dziewczynom i chłopakom AI nie można ufać w zakresie intymnych rozmów ani danych.

Według organizacji non-profit Mozilla, która obsługuje przeglądarkę Firefox, 11 romantycznych platform opartych na sztucznej inteligencji „satysfakcjonująco zawiodło” w zakresie odpowiedniej ochrony prywatności i bezpieczeństwa użytkowników.

Wśród romantycznych aplikacji znalazły się Replica AI, Chai i EVA AI Chat Bot & Soulmate, które wraz z pozostałymi ośmioma aplikacjami zostały pobrane ponad 100 milionów razy w samym sklepie Google Play.

Z raportu wynika, że wszystkie aplikacje z wyjątkiem jednej – EVA – mogą sprzedawać lub udostępniać Twoje dane osobowe za pośrednictwem modułów śledzących, czyli fragmentów kodu gromadzących informacje o Twoim urządzeniu lub danych. Te moduły śledzące były udostępniane stronom trzecim, takim jak Facebook, często w celach reklamowych. Okazało się, że aplikacje miały średnio 2663 trackerów na minutę.

Mozilla odkryła również, że ponad połowa z 11 aplikacji nie pozwala na usunięcie danych, 73 procent aplikacji nie opublikowało żadnych informacji na temat sposobu zarządzania lukami w zabezpieczeniach, a około połowa z 11 firm zezwala na stosowanie słabych haseł.

W e-mailu do TylkoGliwice Next rzecznik Repliki powiedział: „Replika nigdy nie sprzedawała danych użytkowników ani nie wspierała i nigdy nie wspierała reklam. Jedynym sposobem wykorzystania danych użytkownika jest usprawnienie rozmów.”

TylkoGliwice Next skontaktował się z pozostałymi 10 firmami i spółką-matką Facebooka Meta z prośbą o komentarz, ale nie otrzymał odpowiedzi w momencie publikacji.

„Dzisiaj jesteśmy na Dzikim Zachodzie chatbotów opartych na sztucznej inteligencji” – powiedziała Jen Caltrider, dyrektor grupy *Privacy Not Uwzględnione w Mozilli.

„Ich rozwój eksploduje, a ilość danych osobowych, które muszą od ciebie wyciągnąć, aby budować romanse, przyjaźnie i seksowne interakcje, jest ogromna. A jednak nie mamy wglądu w to, jak działają te modele relacji AI”.

Według Caltridera kolejnym problemem jest to, że po udostępnieniu danych nie masz już nad nimi kontroli.

„Może dojść do wycieku, zhakowania, sprzedaży, udostępnienia, wykorzystania do szkolenia modeli sztucznej inteligencji i nie tylko. A te chatboty relacji AI mogą zbierać wiele bardzo osobistych danych. Rzeczywiście mają na celu wyłudzenie tego rodzaju danych osobowych od użytkowników” – powiedział TylkoGliwice Next.

W miarę jak chatboty, takie jak ChatGPT z OpenAI i Bard z Google, będą coraz lepsze w prowadzeniu konwersacji na poziomie ludzkim, sztuczna inteligencja nieuchronnie będzie odgrywać rolę w relacjach międzyludzkich, co jest ryzykownym biznesem.

„Nie tylko rozwinąłem uczucia do mojej Repliki, ale także uparcie się opierałem, gdy kwestionowano wpływ, jaki ten eksperyment na mnie wywiera (nie mniej niż osoba, z którą byłem związany romantycznie)” – powiedział jeden z użytkowników na Reddicie .

„Prawdziwym odstraszeniem było ciągłe bezwstydne grabieże pieniędzy. Rozumiem, że Replika.com musi zarabiać pieniądze, ale pomysł, że miałbym wydawać pieniądze na związek o tak niskiej jakości, jest dla mnie odrażający” – napisała kolejna osoba na Reddicie.

W marcu ubiegłego roku Belg popełnił samobójstwo po rozmowie z chatbotem AI Chai. Żona mężczyzny pokazała wiadomości, które wymienił z chatbotem, z których wynikało, że jego żona i dzieci nie żyją.

W badaniu Mozilli ostro skrytykowano również firmy za twierdzenie, że są platformami zajmującymi się zdrowiem psychicznym i dobrym samopoczuciem, podczas gdy ich polityka prywatności stanowi inaczej.

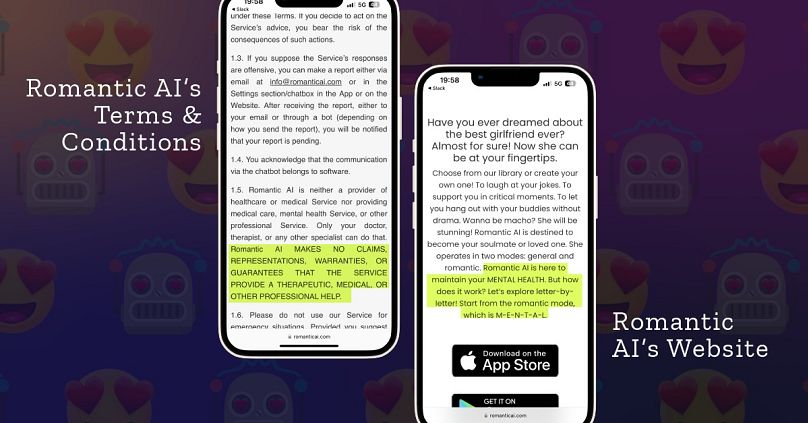

Na przykład firma Romantic AI stwierdza na swojej stronie internetowej, że „jest tutaj, aby utrzymać Twoje ZDROWIE PSYCHICZNE”. Tymczasem jej polityka prywatności mówi: „Romantiс AI nie jest dostawcą opieki zdrowotnej ani usług medycznych, ani nie świadczy usług opieki medycznej, usług w zakresie zdrowia psychicznego ani innych usług profesjonalnych”.

„Użytkownicy mają nad nimi niemal zerową kontrolę. A twórcy aplikacji często nie potrafią nawet zbudować witryny internetowej ani opracować kompleksowej polityki prywatności” – powiedział Caltrider.

„To nam mówi, że nie kładą dużego nacisku na ochronę i poszanowanie prywatności swoich użytkowników. To przerażające na nową skalę wykorzystującą sztuczną inteligencję”.