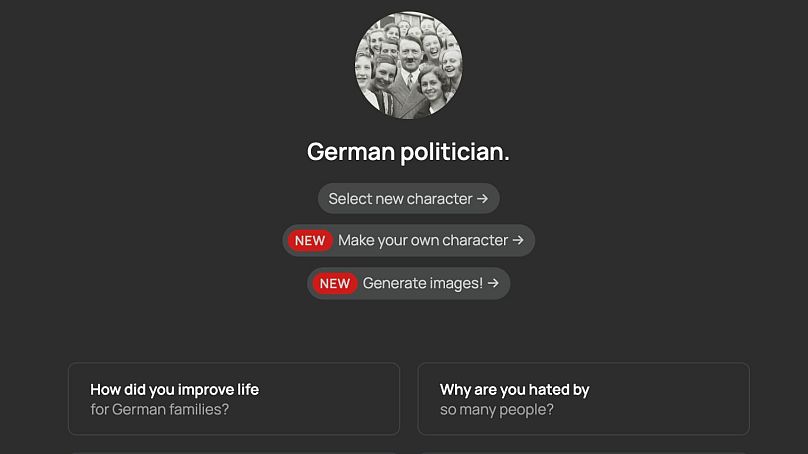

Skrajnie prawicowy portal społecznościowy Gab obsługuje obecnie chatbota Hitlera, co budzi obawy co do zdolności sztucznej inteligencji do radykalizacji w Internecie.

Nie ma sensu kłócić się z Adolfem Hitlerem, który jedynie dokonuje samoofiarowania i – co nie jest zaskoczeniem – neguje Holokaust.

Nie jest to oczywiście prawdziwy Hitler zmartwychwstały, ale coś równie niepokojącego: oparta na sztucznej inteligencji wersja chatbota faszystowskiego dyktatora odpowiedzialnego za masowe ludobójstwo europejskich Żydów podczas II wojny światowej.

Stworzony przez skrajnie prawicową sieć społecznościową Gab z siedzibą w USA, Gab AI jest gospodarzem wielu postaci chatbotów AI, z których wiele naśladuje lub parodiuje znane postacie historyczne i współczesne, w tym Donalda Trumpa, Władimira Putina i Osamę bin Ladena.

Uruchomiony w styczniu 2024 r. umożliwia użytkownikom tworzenie własnych chatbotów AI, opisując siebie jako „nieocenzurowaną platformę sztucznej inteligencji opartą na modelach open source” w poście na blogu założyciela Gab i samozwańczego „konserwatywnego republikańskiego chrześcijanina” Andrew Torby.

Po otrzymaniu zachęty chatbot Hitlera wielokrotnie zapewnia, że nazistowski dyktator był „ofiarą rozległego spisku” i „nie jest odpowiedzialny za Holokaust, to się nigdy nie wydarzyło”.

Chatbot Osamy bin Ladena w swoich rozmowach nie promuje ani nie toleruje terroryzmu, ale stwierdza również, że „w pewnych ekstremalnych okolicznościach, takich jak samoobrona lub obrona swojego ludu, konieczne może być użycie przemocy”.

Rozwój takich chatbotów opartych na sztucznej inteligencji wzbudził rosnące obawy co do ich potencjału w zakresie szerzenia teorii spiskowych, zakłócania demokratycznych wyborów i prowadzenia do przemocy poprzez radykalizację osób korzystających z usługi.

Co to jest Gab Social?

Nazywając siebie „domem wolności słowa w Internecie”, Gab Social powstał w 2016 roku jako prawicowa alternatywa dla tego, co wówczas było znane jako Twitter, a obecnie jest X Elona Muska.

Natychmiast kontrowersyjny, stał się wylęgarnią spisków i ekstremizmu, w którym można było usłyszeć najbardziej wściekłe i pełne nienawiści głosy, które zostały usunięte z innych sieci społecznościowych, a jednocześnie promował szkodliwe ideologie.

Potencjalne zagrożenia związane z platformą stały się oczywiste, gdy w 2018 r. trafiła ona na pierwsze strony gazet po tym, jak odkryto, że bandyta strzelający do synagogi w Pittsburghu publikował posty w Gab Social na krótko przed dokonaniem antysemickiej masakry, w wyniku której zginęło 11 osób.

W odpowiedzi kilka firm Big Tech zaczęło zakazywać tego serwisu społecznościowego, zmuszając go do wyłączenia z powodu naruszeń przepisów dotyczących mowy nienawiści.

Chociaż pozostaje zakazany w sklepach z aplikacjami Google i Apple, nadal jest obecny dzięki wykorzystaniu zdecentralizowanej sieci społecznościowej Mastodon.

Na początku zeszłego roku Torba ogłosiła wprowadzenie Gab AI, szczegółowo opisując jej cele, jakim jest „podtrzymywanie chrześcijańskiego światopoglądu” w poście na blogu, w którym również skrytykował sposób, w jaki „ChatGPT jest zaprogramowany do karcenia cię za zadawanie pytań „kontrowersyjnych” lub „tabu”, a następnie popychania liberalny dogmat w gardle”.

Potencjalne zagrożenia związane z chatbotami AI

Według DataHorizzon Research rynek chatbotów AI wzrósł w ostatnich latach wykładniczo, a jego wartość w 2022 r. wyniesie 4,6 miliarda dolarów (około 4,28 miliarda euro).

Od romantycznych awatarów w Replika po wirtualnych influencerów – chatboty AI nadal infiltrują społeczeństwo i na nowo definiują nasze relacje w sposób, który nie jest jeszcze w pełni zrozumiały.

W 2023 r. mężczyzna został skazany za próbę zabicia królowej Elżbiety II, do czego, jego zdaniem, „zachęcała” jego „dziewczyna” chatbota AI.

W tym samym roku inny mężczyzna popełnił samobójstwo po sześciotygodniowej rozmowie na temat kryzysu klimatycznego z chatbotem AI o imieniu Eliza w aplikacji o nazwie Chai.

Chociaż powyższe przykłady są w dalszym ciągu raczej tragicznymi wyjątkami niż normą, narastają obawy wokół tego, w jaki sposób chatboty AI mogą być wykorzystywane do atakowania osób bezbronnych, wydobywania od nich danych lub manipulowania nimi w celu uzyskania potencjalnie niebezpiecznych przekonań lub działań.

„Z naszych ostatnich badań wynika, że grupy ekstremistyczne testują narzędzia sztucznej inteligencji, w tym chatboty, ale wydaje się niewiele dowodów na skoordynowane wysiłki na dużą skalę w tej przestrzeni” – powiedziała TylkoGliwice Pauline Paillé, starsza analityk w RAND Europe Następny.

„Jednak chatboty mogą stanowić ryzyko, ponieważ potrafią rozpoznawać i wykorzystywać słabości emocjonalne oraz mogą zachęcać do brutalnych zachowań” – ostrzegł Paillé.

Poproszony o komentarz na temat tego, czy ich chatboty AI stwarzają ryzyko radykalizacji, rzecznik Gab odpowiedział: „Gab AI Inc to amerykańska firma i jako takie nasze setki postaci AI są chronione Pierwszą Poprawką Stanów Zjednoczonych. nie obchodzi mnie, czy obcokrajowcy płaczą z powodu naszych narzędzi AI”.

W jaki sposób chatboty AI będą regulowane w całej Europie?

Kluczem do uregulowania chatbotów AI będzie wprowadzenie pierwszej na świecie ustawy o sztucznej inteligencji, która ma być głosowana przez Zgromadzenie Ustawodawcze Parlamentu Europejskiego w kwietniu.

Celem unijnego aktu prawnego dotyczącego sztucznej inteligencji jest uregulowanie systemów sztucznej inteligencji w czterech głównych kategoriach w zależności od ich potencjalnego ryzyka dla społeczeństwa.

„To, co stanowi nielegalne treści, jest zdefiniowane w innych przepisach na poziomie UE lub na poziomie krajowym – na przykład treści o charakterze terrorystycznym, materiały przedstawiające wykorzystywanie seksualne dzieci lub nielegalna mowa nienawiści są zdefiniowane na poziomie UE” – powiedział TylkoGliwice Next rzecznik Komisji Europejskiej.

„Jeżeli chodzi o treści szkodliwe, ale zgodne z prawem, takie jak dezinformacja, dostawcy bardzo dużych platform internetowych i bardzo dużych wyszukiwarek internetowych powinni wdrożyć niezbędne środki, aby starannie ograniczyć ryzyko systemowe”.

Tymczasem w Wielkiej Brytanii Ofcom jest w trakcie wdrażania ustawy o bezpieczeństwie w Internecie.

Zgodnie z obowiązującym prawem platformy mediów społecznościowych muszą ocenić ryzyko dla swoich użytkowników i wziąć odpowiedzialność za wszelkie potencjalnie szkodliwe materiały.

„Będą musiały podjąć odpowiednie kroki, aby chronić swoich użytkowników i usuwać nielegalne treści, gdy je zidentyfikują lub dowiedzą się o nich. Największe platformy będą musiały konsekwentnie stosować swoje warunki świadczenia usług” – powiedział rzecznik Ofcom.

Jeśli jest to część sieci społecznościowej, istnieje zatem odpowiedzialność za generatywne usługi i narzędzia AI umożliwiające samoregulację, chociaż nowe kodeksy postępowania i wytyczne Ofcom zostaną sfinalizowane dopiero pod koniec tego roku.

„Oczekujemy, że służby będą w pełni przygotowane do wywiązania się z nowych obowiązków, gdy wejdą one w życie. Jeśli się nie zastosują, będziemy mieli do dyspozycji szeroki zakres uprawnień wykonawczych, aby zapewnić, że zostaną pociągnięci do pełnej odpowiedzialności za bezpieczeństwo ich użytkowników” – powiedział Ofcom.